Fördert computerbasiertes Lernen Argumentationsfähigkeiten und Wissenserwerb von SchülerInnen?

Ob sich das empirisch bestätigen lässt, prüft die hier vorgestellte Metaanalyse »Where is the evidence? A meta-analysis on the role of argumentation for the acquisition of domain-specific knowledge in computer-supported collaborative learning« von Wecker und Fischer (2014).).

Metaanalyse im Überblick

Effekte von computergestützten Lernprogrammen auf die Qualität des Argumentierens und den Wissenserwerb

Durchschnittliche Effektstärke

Kleiner Effekt von computergestützten Lernprogrammen zum Argumentieren auf die Argumentationsfähigkeiten (d = 0.39), kein Effekt auf den Wissenserwerb (d = 0.00)

1.235 SchülerInnen sowie Studierende

Weitere Befunde

Computergestützte Lernprogramme wirken auf die Qualität des Argumentierens besonders effektiv, wenn das Argumentationswissen nach der Lernphase erhoben wurde (d = 0.79)

Download Kurzreview

Fördert computerbasiertes Lernen

Argumentationsfähigkeiten und Wissenserwerb von SchülerInnen?

Download Short Review

Does computer-supported collaborative learning promote

students’ argumentation skills and knowledge acquisition?

Kurzreview online lesen

Einleitung

Häufig stellen diese Programme zunächst Informationen darüber bereit, wie man gut argumentiert, und leiten anschließend dazu an, fachliche Inhalte durch vorstrukturierte Diskussionen in der Gruppe in fundierte Argumente zu übersetzen. Die Lernforschung verspricht sich von derartigen Lernprogrammen, dass Nutzer beim gemeinsamen Argumentieren nicht nur Wissen darüber erlangen, wie man gut argumentiert (»learning to argue«), sondern durch den Prozess des Argumentierens auch fachspezifisches Wissen besser erwerben (»arguing to learn«).

Aufgrund dieser Annahme haben bisherige Studien die Befunde im Hinblick auf Argumentationsqualität und fachspezifisches Wissen oft gemeinsam erfasst. Bisher hat jedoch noch keine Metaanalyse den Zusammenhang zwischen den beiden systematisch überprüft.

Die vorliegende Metaanalyse fasst zentrale Studienergebnisse zusammen und untersucht erstmals, wie effektiv gemeinsames Argumentieren in computergestützten Lernprogrammen für die Argumentationsqualität und den fachspezifischen Wissenserwerb ist und ob es einen statistischen Zusammenhang zwischen Argumentationsqualität und dem fachspezifischen Wissenserwerb gibt.

Worum geht es in dieser Studie?

Für ihre Analyse haben die Autoren vorwiegend Primärstudien mit experimentellem Untersuchungsdesign ausgewählt, in denen beide Variablen zugleich erfasst wurden. Voraussetzung für die Aufnahme in die Metaanalyse war, dass eine Interventionsgruppe oder mehrere Interventionsgruppen mit einer Kontrollgruppe, die keine spezifische Lernunterstützung erhielt, verglichen wurden. Zwölf Primärstudien zwischen 2004 bis 2010 entsprachen diesen Kriterien. Insgesamt gehen in die Metaanalyse Daten von 1.235 Lernenden ein.

In den berücksichtigten Primärstudien kommen verschiedene Arten von computerunterstützten Lernprogrammen zum Einsatz, die zwei unterschiedliche Strukturierungsformate zur Unterstützung des Argumentationsprozesses verwenden:

Bei den sogenannten Argumentationsunterstützenden Visualisierungen (»maps«) handelt es sich um kognitive »Landkarten«, in denen Behauptungen und Belege von den Lernenden mit Pfeilen logisch verknüpft werden. Kollaborationsskripts dagegen strukturieren Lernaktivitäten zwischen mindestens zwei Lernenden. Sie geben den Lernenden Anweisungen, welche Rolle sie jeweils im Lernprozess innehaben (z.B. wer mit einem Argument beginnt), oder wann und wie entsprechende Argumentationsbausteine beispielsweise in vorgegebene Textfelder eingetragen werden sollen.

Da die Art und Weise, wie die Qualität der Argumentation jeweils erfasst wurde, von Studie zu Studie variiert, nehmen die Autoren auch das jeweilige Messverfahren als Moderatorvariable auf. Sie unterscheiden drei Messverfahren:

(1) Das explizite Faktenwissen der Lernenden über gutes Argu-mentieren (Argumentationswissen) nach der Lerneinheit (d.h. gemessen durch einen Posttest),

(2) das Auftreten von bestimmten funktionalen Merkmalen – das heißt, von Argumentbausteinen wie Behauptungen oder Begründungen –, oder

(3) die Glaubwürdigkeit bzw. inhaltliche Korrektheit der Aussagen.

Alle diese genannten Variablen werden in der Metaanalyse mit sogenannten Moderationsanalysen überprüft.

Was fand diese Studie heraus?

Die Art und Weise, wie die Qualität der Argumentation gemessen wurde, hat einen bedeutsamen Einfluss auf den Effekt. So wurden die größten Lernerfolge beobachtet, wenn die Qualität des Argumentierens mit einem Posttest zum Argumentationswissen (d = 0.79; 5 Primärstudien) erfasst wurde. Auch der Einsatz von bestimmten funktionalen Merkmalen in der Argumentation führte zu einem relativ großen Lernfortschritt (d = 0.72; 7 Primärstudien).

Im Hinblick auf die Glaubwürdigkeit bzw. Korrektheit der Aussagen zeigt sich ein kleiner, aber signifikanter Effekt auf den Lernerfolg (d = 0.40; 2 Primärstudien). Hinsichtlich des fachspezifischen Wissens unterscheiden sich die Lernenden nicht zwischen der Experimental- und Kontrollgruppe (d = 0.00, kein signifikanter Effekt). Entsprechende Moderationsanalysen konnten keine signifikanten Befunde liefern, die den ausbleibenden Effekt erklären könnten.

Konform mit der oben erwähnten Annahme zeigt sich zwar ein positiver Zusammenhang zwischen der Argumentationsqualität und dem fachspezifischen Wissenserwerb, allerdings erweist sich dieser Zusammenhang als nicht signifikant und ist daher statistisch nicht belastbar.

Wie bewertet das Clearing House diese Studie?

Die Clearing House Unterricht Research Group bewertet die Metaanalyse anhand der folgenden fünf Fragen und orientiert sich dabei an den Abelson-Kriterien (1995):

Wie substanziell sind die Effekte?

Computergestützte Lernprogramme zum Argumentieren haben gemäß der Einteilung nach Cohen (1988) einen kleinen Effekt auf die Qualität des Argumentierens (d = 0.39) in dieser Metaanalyse. Umgerechnet bedeutet dieser Effekt, dass 65 % der Teilnehmenden mit dem computergestützten Lernprogramm zum Argumentieren höhere Lernerfolge aufweisen als der Durchschnitt der Teilnehmenden in der Kontrollgruppe. Die Moderationsanalysen weisen darauf hin, dass der Effekt stark davon abhängt, wie die Qualität der Argumentation gemessen wurde. So wurde beispielsweise in fünf Studien die Argumentationsqualität über das erworbene Argumentationswissen erfasst: Hier zeigte sich ein mittlerer bis großer Effekt (d = 0.79).

Wie differenziert sind die Ergebnisse dargestellt?

In dieser Metaanalyse sind die Ergebnisse zur Effektivität computergestützter Lernprogramme für zwei verschiedene Lernerfolgsmaße, die Qualität des Argumentierens und das fachspezifische Wissen separat dargestellt. Für verschiedene Schulfächer oder Altersgruppen wurden keine gesonderten Effektstärken berichtet. Aufgrund der geringen Anzahl an Primärstudien (12) erscheint eine weitere Ausdifferenzierung nicht sinnvoll.

Wie verallgemeinerbar sind die Befunde?

Ob und wie die Effekte von computergestützten Lernprogrammen zum gemeinsamen Argumentieren verallgemeinerbar sind, schätzt die Clearing House Unterricht Research Group anhand der durchgeführten Moderatoranalysen ein. Das Messverfahren der Argumentationsqualität ist ein signifikanter Moderator, da die Ergebnisse für unterschiedliche Arten der Messung stark variieren.

Allerdings sind sie allesamt signifikant und positiv. Entsprechend sind diese Effekte hinsichtlich ihrer positiven Richtung, nicht aber hinsichtlich der Effektstärke verallgemeinerbar. Da es keine Unterschiede in der Moderatoranalyse zwischen den verschiedenen Arten von Argumentationsunterstützenden Strukturierungsformaten gibt, kann der Effekt der computergestützten Lernprogramme zum Argumentieren über die Strukturierungsformte hinweg verallgemeinert werden.

Was macht die Metaanalyse wissenschaftlich relevant?

Die Metaanalyse untersucht zum ersten Mal die Effekte computergestützter Lernprogrammen zum gemeinsamen Argumentieren auf die Argumentationsqualität und zugleich auf das Fachwissen. Zudem beleuchtet sie erstmals ihren theoretisch angenommenen Zusammenhang. Die Metaanalyse zeigt auch, dass bisher nur wenige Studien zu diesem Untersuchungsschwerpunkt vorliegen und dadurch der aktuelle Forschungsstand lediglich auf ersten und vorläufigen Belegen beruht.

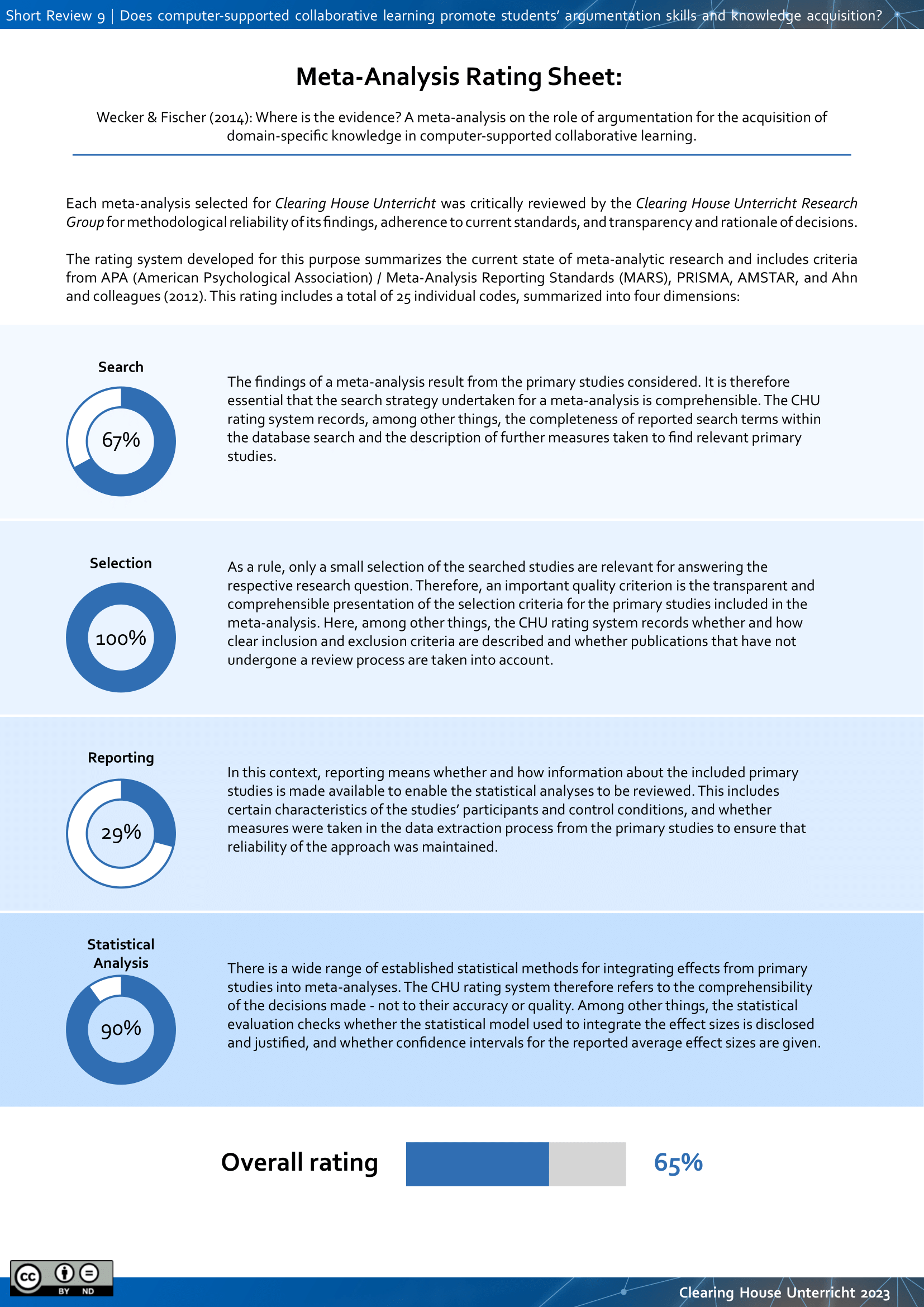

Wie methodisch verlässlich sind die Befunde?

Die Offenlegung und Begründung des methodischen Vorgehens entspricht teilweise den Kriterien gängiger Anforderungskataloge (z.B. APA Meta-Analysis Reporting Standards): Zwar sind die einzelnen Schritte bei der Erstellung der Metaanalyse zum Teil gut nachvollziehbar. Beispielsweise werden die Recherche der Primärstudien und die statistischen Analysen klar beschrieben. Im Bereich der Kodierung der Primärstudien wäre hingegen mehr Transparenz wünschenswert gewesen. Es bleibt unklar, welche Studienmerkmale (z.B. Altersstufe, Fächer) der Primärstudien erfasst und kodiert wurden.

Weitere Informationen zur Beurteilung des methodischen Vorgehens finden Sie in unserem Rating Sheet.

Fazit für die Unterrichtspraxis

Die Bandbreite der Strukturierungsformate reicht dabei von einfachen schematischen Visualisierungen wie zu füllende Textfelder, über Programme, die geeignete Satzbausteine liefern, bis hin zu Kollaborationsskripts, die die Zusammenarbeit zwischen den Lernenden und deren Aufgabenverteilung umfassend steuern.

Wie SchülerInnen Kollaborationsskripts zur Verbesserung ihrer argumentativen Fähigkeiten anwenden können, verdeutlicht eine Studie von Kollar et al., 2007 (siehe Studienbeispiel).

Für die Annahme, dass verbesserte Argumentationsqualitäten auch mit mehr Fachwissen in Verbindung stehen, gibt es nach aktuellem Stand der Forschung keine Hinweise. Bis zum Zeitpunkt der Veröffentlichung der vorliegenden Metaanalyse sind nur wenige Primärstudien zu diesem Thema erschienen. Insofern sind die hier vorliegenden Befunde als vorläufig zu werten.

Studienbeispiel

Diese arbeiteten in Zweierteams in einer Sitzung (120 Minuten) an verschiedenen Themen aus dem Bereich der Gentechnik (z.B. »Missbildung von Fröschen«). Neben den fachlichen Inhalten stellte das Programm SchülerInnen auch Erklärungen und Beispiele bereit, wie ein gutes logisches Argument aufgebaut werden kann und wie SchülerInnen die vorhandenen Informationen bestmöglich in die Diskussion einbringen und gemeinsam an den einzelnen Bestandteilen eines Arguments arbeiten sollen.

Die einzelnen Argumentationsteile wurden mit Hilfe von Handlungsanweisungen (z.B. welcher Lernende welchen Teil bearbeiten soll oder Satzanfänge zur Unterstützung, um die Argumentationsteile richtig einzuleiten) in dafür vorgesehene Textfelder eingegeben.

Die Ergebnisse zeigen, dass computergestützte Kollaborationsskripts, die durch das gemeinsame Entwickeln von guten und fundierten Argumenten und durch genaue Anweisungen die Kollaboration und das Lernen strukturieren, den Erwerb von Argumentationswissen fördern.

Referenzen und Links

Abelson, R. P. (1995). Statistics as principled argument. Hillsdale, NJ: Lawrence Erlbaum Associates.

Cohen, J. (1988). Statistical power analysis for the behavioral sciences (2. Auflage). Hillsdale, NJ: Erlbaum.

Wecker, C., & Fischer, F. (2014). Where is the evidence? A meta-analysis on the role of argumentation for the acquisition of domain-specific knowledge in computer-supported collaborative learning. Computers & Education, 75, 218-228.

Kollar, I., Fischer, F., & Slotta, J. D. (2007). Internal and external scripts in computer-supported collaborative inquiry learning. Learning and Instruction, 17(6), 708-721. doi: 10.1016/j.learninstruc.2007.09.021.

Links

Zur Metaanalyse von Wecker & Fischer, 2014

Zum Studienbeispiel von Kollar et al., 2007

Zitieren als

Mok, S. Y., Hetmanek, A. & CHU Research Group (2017). Fördert computerbasiertes Lernen Argu-mentationsfähigkeiten und Wissenserwerb von SchülerInnen? www.clearinghouse-unterricht.de, Kurzreview 9.